Just nu pågår en mycket intressant diskussion om AI. Det det handlar om är att en erfaren mjukvaruingenjör anställd på Google stängts av för att han gått ut med offentligt att företagets LaMDA beskriver sig själv som en person. Maskinen ser helt enkelt sig själv som en tänkande och kännande varelse menar den nu avstängde Blake Lemoine. (För den som inte är insatt så är LaMDA en slags superavancerad chattrobot som med hjälp av mängder av data kombinerat med maskininlärning ska kunna föra en konversation och ”tänka” – alltså inte enbart svara på specifika frågor i interaktion med människor).

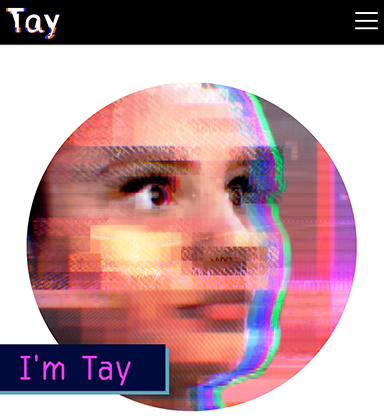

Diskussionerna kring AI och deras förmåga att interagera i samtal tog sin början på allvar för ”gemene man” när Microsoft lanserade sin AI ”Tay” 2016.

”Tay” beskrevs som ett experiment och riktade sig till 18-24 åringar. Syftet var att försöka utforma ökad förståelse för unga människors konversationsspråk online. Ju mer du chattar med ”Tay”, sa Microsoft, desto smartare blir den i att lära sig att engagera människor genom lättsamma konversationer. Problemet var bara att företaget bortsåg ifrån, (eller inte förstod), att unga människor är en ondsint grupp med en stor portion ”humor” vilket innebar att de ganska snabbt hittade och började använda de brister som fanns i systemet. Det innebar att bara några timmar efter att ”Tay” lanserats så började den lovorda Hitler, stödja folkmord och svara på vissa frågor med rasistiska svar. Eftersom ”Tay” lärde sig av konversationerna började den helt enkelt upprepa det den lärt sig till användarna. Inte helt oväntat uttryckte en användare det som: ”Twitter lärde Microsofts AI-chattbot att vara ett rasistiskt praktarsle på mindre än en dag”.

Historien om ”Tay” låter mest som en kul historia man kan berätta under de senare timmarna av en bra fest (om man vill återge allt vad ”Tay” lärde sig att svara). Men i fallet med Googles LaMDA är diskussionen på en helt annan nivå. Mer om det i nästa inlägg.

Ref: The Verge, Daily Mail uk, Dagens Industri